El fichero robots.txt es un fichero, enfocado a los robots rastreadores de los buscadores, que tiene varias utilidades.

- Por una parte es una manera de indicar a los buscadores dónde tenemos nuestro(s) sitemap (mapa de sitio). Esto se hace con el parámetro sitemap en el fichero:

sitemap urldelmapadelsitio.

Es verdad que la mayoría de las herramientas de los buscadores tienen un apartado para enviarles esta ruta, pero no solemos hacerlo para todos los buscadores….y nunca está de más hacerlo aquí. - Por otro lado, nos permite bloquear ciertos lugares de nuestro sitio web (directorios, ficheros, urls) para que los buscadores no los recorran y no los indexen. Esto es importante por tres motivos:

– Seguridad: los buscadores no deberían estar entrando, ni publicando, información de zonas como wp-admin o directorios donde podemos tener copias de seguridad o similar. Esto puede ser una manera de acceder a nuestra página web.

– SEO: podemos controlar qué queremos y qué no queremos que aparezca en los buscadores. Esto también se puede hacer, de manera más sencilla pero limitada, desde Yoast.

– Optimización de recursos: en ocasiones ciertos robots de los buscadores, que además no nos interesan, pueden estar usando recursos de nuestra web. Por ejemplo buscadores de países que no son nuestro objetivo, o buscadores que se sabe que son “no deseados”. Podemos bloquear muchos de estos desde aquí.

Dónde se coloca y cómo se edita el fichero robots.txt.

El fichero robots.txt se coloca en la raíz de nuestro sitio. Podemos crear el fichero por FTP y subirlo a la raíz de nuestro sitio. Y editarlo desde FTP.

Nota: cuidado con el UTF-8 BOM (la introducción de carácteres invisibles en nuestro fichero de texto que hacen que los robots no puedan leerlo).

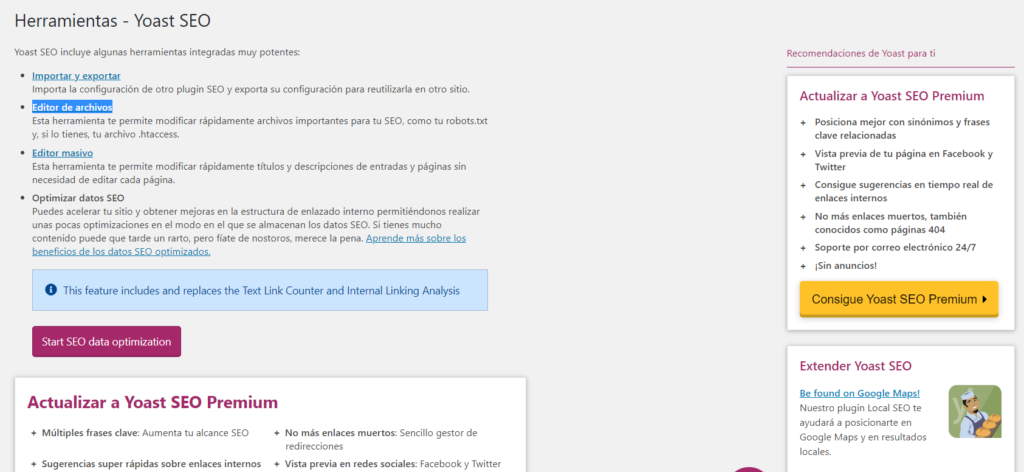

WordPress no permite editar este fichero a mano, pero si tienes Yoast instalado, puedes hacerlo fácilmente desde SEO-> Herramientas->Editor de archivos

Fichero robots.txt recomendado para WordPress.

Aquí os dejamos un fichero genérico que recomendamos para WordPress. Recordamos que cada instalación es diferente, y es conveniente verificar si queremos añadir algo más a nuestro fichero.

Nota: Algunas líneas se añaden para asegurarnos que se admite esa ruta aunque por defecto lo debería hacer.

# Admitimos y bloqueamos ciertos sitios.

User-agent: *

Allow: /wp-content/uploads/

Disallow: /wp-content/plugins/

Disallow: /wp-admin/

Disallow: /tienda/

Disallow: /readme.html

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

# Aquí indicamos dónde está nuestro sitemap

Sitemap: https://tudominio/sitemap_index.xml

# No indexar copias de seguridad

Disallow: /*.sql$

Disallow: /*.tgz$

Disallow: /*.gz$

Disallow: /*.tar$

Disallow: /*.svn$

# Evita bloqueos de CSS y JS.

Allow: /*.js$

Allow: /*.css$Si queréis bloquear robots poco útiles os dejamos algunos.

# Bloqueo de bots y crawlers poco utiles

User-agent: MSIECrawler

Disallow: /

User-agent: WebCopier

Disallow: /

User-agent: HTTrack

Disallow: /

User-agent: Microsoft.URL.Control

Disallow: /

User-agent: libwww

Disallow: /

User-agent: Orthogaffe

Disallow: /

User-agent: UbiCrawler

Disallow: /

User-agent: DOC

Disallow: /

User-agent: Zao

Disallow: /

User-agent: sitecheck.internetseer.com

Disallow: /

User-agent: Zealbot

Disallow: /

User-agent: MSIECrawler

Disallow: /

User-agent: SiteSnagger

Disallow: /

User-agent: WebStripper

Disallow: /

User-agent: WebCopier

Disallow: /

User-agent: Fetch

Disallow: /

User-agent: Offline Explorer

Disallow: /

User-agent: Teleport

Disallow: /

User-agent: TeleportPro

Disallow: /

User-agent: WebZIP

Disallow: /

User-agent: linko

Disallow: /

User-agent: HTTrack

Disallow: /

User-agent: Microsoft.URL.Control

Disallow: /

User-agent: Xenu

Disallow: /

User-agent: larbin

Disallow: /

User-agent: libwww

Disallow: /

User-agent: ZyBORG

Disallow: /

User-agent: Download Ninja

Disallow: /

User-agent: wget

Disallow: /

User-agent: grub-client

Disallow: /

User-agent: k2spider

Disallow: /

User-agent: NPBot

Disallow: /

User-agent: WebReaper

Disallow: /

Cómo comprobamos el fichero robots.txt

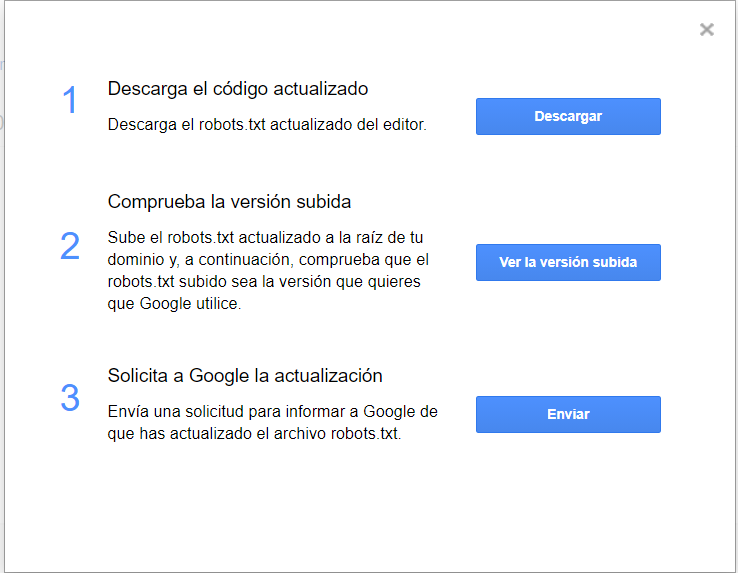

Siempre es importante comprobar que el fichero robots.txt es correcto. Para ello Google tiene una herramienta desde la que podemos hacerlo. También nos permite actualizar el contenido si lo hemos cambiado.

https://www.google.com/webmasters/tools/robots-testing-toolEn la ventana que te aparece tras elegir tu sitio, si no aparece el código actualizado puedes copiar el código nuevo y darle a Enviar . Después vuelve a pinchar en Enviar para que lo actualice. En ese momento te dirá si tienes algún error.

Os recomendamos los siguientes productos relacionados con la informática: